Cátedra AMIDI

Por Juliana Raffaghelli

La era de la datificación

Entramos en la era de la datificación, un término que encierra tanto controversias y miradas de entusiasmo como de crítica y desilusión. Entramos casi sin darnos cuenta, mientras nos íbamos poniendo más y más cómodos y cómodas con las tecnologías digitales en nuestras vidas. Tanto, que parecían hacerse invisibles.

Sin embargo, la datificación, ese fenómeno que se basa en el uso comercial de grandes volúmenes de datos extraídos a partir de nuestro masivo «vivir» en espacios digitales, iba incubándose bajo el internet visible, libre, prosocial. Con uso comercial o monetización de nuestros datos digitales me refiero a modelos de recomendación de comportamientos de consumo, detección de clientes, generación de servicios basados en los perfiles extraídos; con espacios digitales me refiero a nuestras búsquedas en Internet, nuestro uso de aplicaciones desde nuestros móviles y, por supuesto, nuestra gran afección por comunicar y ser vistas, vistos, en redes sociodigitales.

¿Qué impactos tiene la datificación en la (in)justicia social? ¿Es un fenómeno negativo? ¿La acción educativa orientada a alfabetizar respecto de la datificación será suficiente para cambiar (o resistir) este fenómeno?

Vamos a tratar de responder esas preguntas en este espacio, avisando a la audiencia que proponemos una mirada particular sobre un problema que está evolucionando y produciendo mucho debate, interés en medios y bibliografía específica. Por lo tanto, este artículo es una invitación a profundizar.

Datificación e injusticias

Cuando una tecnología emerge en la vida social es frecuentemente acompañada por movimientos y discursos hiperbólicos que, tarde o temprano, la realidad —o más bien una crítica organizada desde movimientos sociales o académicos— logra deconstruir. Las metáforas que caracterizan el discurso social sobre una tecnología emergente son un buen indicador de esos movimientos, así que haremos un breve recorrido por algunas de las más salientes en relación con la datificación (y que yo traté en este artículo académico).

Todo empezó con la metáfora del «nuevo oro negro» de los datos (aquí un ejemplo sobre cómo circulaba el término en el mundo comercial y aquí otro). Esta venía a plantear lógicas extractivas — asociadas a métodos como la minería de datos— aplicadas a los macrodatos (Big Data), que podían ser extraídos sin pausa desde los motores de búsqueda y redes sociodigitales, pero también desde dispositivos de Internet de las Cosas como sensores y webcam instalados en ambientes en los que nos movemos (desde el metro hasta el supermercado), para finalizar en nuestros móviles con sus cientos de aplicaciones, y los dispositivos inteligentes que hemos comenzado a incluir en nuestras vidas —asistentes de voz (Alexa, Siri) relojes (Fitbit, Garmin), aspiradoras (Roomba) o heladeras (Samsung), para mencionar solo unos pocos—. Esta captura continua de datos fue generando una aceleración de la personalización de sistemas y servicios digitalizados concluyendo, finalmente, en el desarrollo de la industria de la Inteligencia Artificial (IA) que, como podemos seguir en informes de la OCDE o la Unión Europea, pasaría a ser una pieza central de las economías avanzadas.

En pocos años el riesgo de ese enfoque salió a la luz. En su trabajo temprano sobre medios y sociedad, la estudiosa holandesa Jose van Dijck, hablaba de dataísmo (en obvia relación con la ingenuidad que conlleva otro término proveniente del arte, el dadaísmo) y data-vigilancia (en inglés «dataveillance», es decir, data + surveillance) y ya indicaba algunos de los efectos perversos de la datificación. El trabajo de varias mujeres apuntó a varias injusticias de la datificación, captadas por ellas desde sus lugares interseccionales entre género, raza y pertenencia al Sur Global.

En el 2016, Cathy O’Neil, matemática, hablaba de armas de destrucción matemática seguida por Safiya Noble (2018) con su metáfora de algoritmos de la opresión y Virgina Eubanks, automatizando la inequidad. En el 2018, Jose van Dijck lanzaba un libro en el cual conceptualizaba un fenómeno aún poco comprendido y ya muy presente entonces (que además abrirá toda una línea de trabajo de investigación educativa): el de la sociedad de las plataformas. Hacía referencia, en ese trabajo, a la forma dada a la interacción con la digitalidad, no siendo ya internet ni mucho menos apps sueltas las que gobiernan el interés (y capturan la atención), sino infraestructuras digitales con sus propias reglas, espacios y políticas de buen comportamiento. Plataformas como Facebook y TikTok o, en el campo de la educación y para nosotros y nosotras conocidas, Google Classroom o Pearson; pero también Amazon Web Services con su oferta de nube con soluciones integradas; y también las plataformas de teletrabajo (entre otras) como We Work Remotely, Domestika, Bolt, Glovo, cubriendo desde servicios profesionales hasta servicios de transporte o delivery. En estos casos, se develaba la imposición de comportamientos, de captura de la atención y de ritmos de interacción (o trabajo) a partir de las características de las plataformas adoptadas.

Muy poco después se publicaba el excepcional trabajo de Shoshana Zuboff (2019) quien, cabe destacar, ofrecía una lente teórico-conceptual incomparable para leer nuestro tiempo, denominándolo «la era del capitalismo de vigilancia» debido a las técnicas extractivas que ya hemos mencionado, y la desigualdad de condiciones entre quién accede a los datos —grandes empresas tecnológicas o Big Tech— y quién los cede —nosotros mismos—.

Desplazando la interseccionalidad al ser parte del Sur Global, Paola Ricaurte (2019), estudiosa del Instituto Tecnológico de Monterrey, ofrecía una metáfora potente: colonialismo de datos. A través de la misma, ella estará entre las primeras en comprender las problemáticas inherentes al impacto que la manipulación algorítmica pensada en el Norte puede tener sobre la identidad de quien vive en el Sur Global.

Para cerrar este listado (que no es ni por lejos exhaustivo, sino que hace un cribado de trabajos que han circulado mucho y que han apoyado la opinión pública), en el 2021 Kate Crawford, con su Atlas de la IA trae la metáfora de un explorador que se mueve a través de «territorios» del desarrollo tecnológico, no ya desde las temáticas o desde los tipos de discriminación, sino poniendo de manifiesto niveles o «capas» constituyentes de la IA, desde la intensiva explotación de recursos naturales y humanos a la invisibilización de dichos procesos en los productos IA que consumimos.

Estas pioneras, con sus conceptualizaciones eficaces y profundamente ligadas a un trabajo de campo meticuloso, fueron construyendo un campo de crítica a los mecanismos de la datificación en la que justamente se desmontaban los algoritmos como dispositivos «objetivos». Sus metáforas fueron más allá de la academia para circular en la opinión pública y permitieron comprender a la ciudadanía común el tipo de amenaza que se cernía en gestos tan comunes como poner «me gusta» en una red social o usar la geolocalización para orientarse en la ciudad. Especialmente, fueron mostrando la matriz epistémica patriarcal y colonial de la datificación, estudiando casos en los que se mostraba cómo lógicas algorítmicas entraban en colisión con el reconocimiento de identidades otras respecto a la masculinidad blanca del Norte Global. Su presencia, desde su identidad otra no fue casual, como podemos imaginarlo.

La búsqueda de justicia (de datos)

La perspectiva distópica sugerida en la sección anterior presenta al centro un sujeto pasivo, incapaz de controlar el flujo de sus propios datos y por lo tanto víctima de la manipulación algorítmica. Sin embargo, existe una contracultura del activismo de datos —comentado por Miren Gutiérrez— donde los sujetos se vuelven protagonistas creativos y contestatarios del sistema propio a través de las mismas tecnologías observadas críticamente en el apartado anterior. Los grupos involucrados en dicho activismo tienen como objetivo descubrir las formas sutiles de vigilancia y redistribuir el poder a través de la apropiación participativa de datos (Lehtiniemi & Ruckenstein, 2019). Hay, por tanto, una búsqueda de reconocimiento, conciencia, redistribución del poder simbólico y material orientado a la emancipación ciudadana y política (Baack, 2015), de género y raza (D’Ignazio & Klein, 2020).

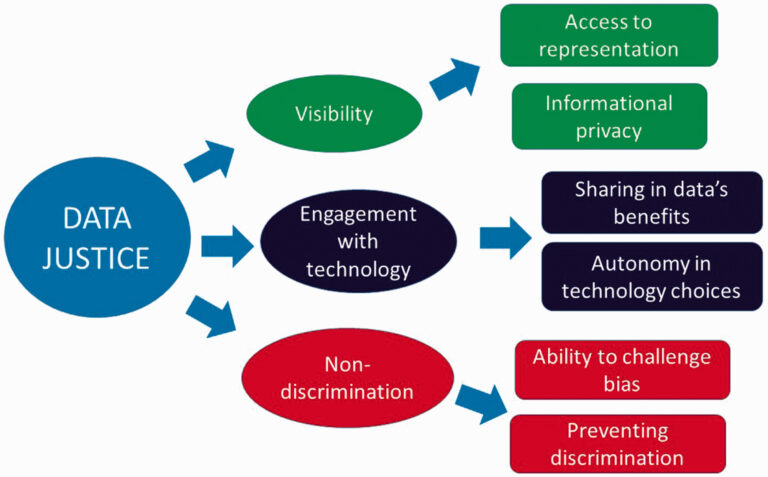

Es así que surgen propuestas conceptuales de justicia de datos. En este sentido, Linnet Tylor (2017) propone un modelo basado en tres pilares que cristalizan las necesidades antes señaladas:

- Deconstruir la (in) visibilidad de las tecno-estructuras.

- Intervenir sobre el (des)compromiso de los tecnólogos y científicos de datos.

- Explorar las formas de discriminación para combatirlas.

Tres pilares de la justicia de datos:

En este sentido, no deberíamos hablar únicamente del poder de las Big Tech, sino también de cualquier actor (organización o individuo) que recoge datos de una manera no solo no informada, sino mal informada y por lo tanto consensuada (de alguien con los otros) de manera superficial, como ha sido puesto de manifiesto en el trabajo sobre «qué se entiende y qué se pierde» en un consentimiento informado en la investigación educativa (concepto extensible a otros campos de la investigación biomédica y social, claro está) (Beardsley et al., 2019) .

Siguen otros estudios sobre la interacción humana con datos y la necesidad de transparencia, negociabilidad y de expresión de las identidades de las personas, como el caso del colectivo Human-Data Interaction.

Es evidente, pues, la necesidad de configurar la justicia de datos como objeto de estudio, no solo del impacto de la datificación, sino del porqué y cómo se generan estructuras que permiten situaciones injustas. Por ejemplo, en el caso del uso de plataformas de aprendizaje, no se trata ya de que un algoritmo clasifique de manera parcial y con errores a un grupo de estudiantes, sino de pensar por qué se usa esta infraestructura y estos modelos de clasificación, y cómo el uso de esa tecnología da forma a prácticas y discursos (por ejemplo, la diferencia entre plataformas privativas y Moodle, que es un Learning Management System de código abierto). Esto sienta las bases para tener más transparencia, negociabilidad y respeto por la identidad cuando se generan términos y condiciones o consentimiento informado.

Justicia de datos y alfabetizaciones ¿justas?

La oferta de formación en datos ha crecido intensamente en los últimos años, sin embargo, los contenidos, características e ideologías encerradas en esa oferta formativa se han ido alineando con el desarrollo tecnocrático.

En el 2017 hice un análisis sobre el proceso de desarrollo de la oferta formativa en Italia (Raffaghelli, 2017), que partía de la creación de un grupo de trabajo ministerial en el 2016 para apoyar Máster universitarios y monitorear MOOC (Massive Open Online Courses, cursos masivos abiertos en línea) y microcursos orientados, más que nada, al desarrollo de habilidades de data science. En efecto, la formación más refinada ofrecida por los MOOC, la formación continua y la educación superior abordaron rápidamente el aspecto técnico del trabajo con datos, con la promesa de una colocación laboral segura.

En lo que respecta a la educación obligatoria, se ha hecho mucho énfasis en los últimos años en torno a la codificación (Popat & Starkey, 2019), el movimiento maker (Papavlasopoulou et al., 2017) y la competencia digital. Sobre esta última, veamos por ejemplo el enfoque de la Comisión Europea para dar un marco de formación a todos los países de la unión, desde la versión 2.1 y su evolución en la versión 2.2.

El debate en torno a la alfabetización de datos pasó por etapas similares y abarcó varios temas, como lo comenté junto a otros autores en este artículo focalizado en la educación superior. A través de una serie de reflexiones surgidas del debate sobre la aritmética, que se trasladó a la alfabetización estadística y, por lo tanto, a la alfabetización en datos, el efecto fue el de abordar la comprensión técnica de algoritmos, prácticas basadas en datos, visualización de datos y programación como lado creativo de la ciencia de datos. Alineándose con esta tendencia, los entornos digitales y las herramientas para procesar y visualizar datos, así como las oportunidades de desencadenar representaciones dinámicas, recomendaciones o actividades, abrieron un área de desarrollo de habilidades en la educación superior. Consideremos por ejemplo el marco de competencia en datos del Open Data Institute.

Sin embargo, todos estos enfoques poseen como elemento común el centrarse en nociones y prácticas que se conectan a la idea de innovación y desarrollo ligada a un paradigma positivista y neo-conductista, que no se ocupa de comprender los riesgos personales ni mucho menos sociales de alimentar una tecno-estructura monopólica, invisibilizando la complejidad de los entramados socio-técnicos y políticos, como lo comentaba en mi trabajo señalado más arriba y también comento en una charla invitada por la Serie de Seminarios Web «Educar con Sentido».

Por lo tanto, los enfoques de alfabetización de datos que se centran en desarrollar las habilidades y el conocimiento necesarios para la tecno-estructura existente —es decir, con un foco en las habilidades de la élite de científicos de datos— refuerzan un oxímoron: no hay «justicia de datos» donde justicia y dato pueden encerrar tendencias de pensamiento totalmente opuestas. En estos términos, más alfabetización podría implicar la profundización de injusticias estructurales, pues las habilidades adquiridas orientarían prácticas de apoyo al poder y de desentendimiento de los fines últimos de la actividad técnica en la que un científico de datos se involucra.

No se pierdan el post «Alfabetización crítica en datos: ¿nos bastará para conquistar la justicia social en la era de la datificación? », donde seguimos explorando esta idea con una propuesta sobre qué alfabetizaciones necesitamos para superar el oxímoron.

Para seguir aprendiendo

- Activismo en datos desde la educación superior, un compromiso académico (Data Praxis) | Módulo de taller sobre activismo académico en datos.

- Fair Data Cultures in Higher Education (2019-2022) | Serie de webinarios

- Justicia de los datos. El rol del educador (Data Praxis, 2019)| Módulo de taller sobre justicia de datos.

***

Juliana Raffaghelli. Profesora Investigadora de la Universidad de Padua, Italia. Recientemente investigadora principal Ramón y Cajal (Ministerio de Investigación e Innovación de España, en la Universitat Oberta de Catalunya, 2018-22), donde exploró las vías para desarrollar una visión compleja de la datificación en la sociedad y en la educación.

***

Este texto se publicó originalmente en: